Z tego artykułu dowiesz się jak działa wyszukiwarka Google oraz jakie algorytmy odpowiedzialne są za wyświetlanie wyników użytkownikom sieci. Poruszymy także temat aktualizacji algorytmów, które ze względu na swoje rozmiary, przeszły do historii SEO pod własnymi nazwami.

Informacje zawarte w artykule:

Jak działa wyszukiwarka Google

Wyszukiwarka Google wykorzystuje system rankingowy, by ułatwić znalezienie nam najpotrzebniejszych informacji. Ranking stron internetowych ustalany jest przez szereg algorytmów, które nieustannie analizują miliony stron w celu uszeregowania ich według przyjętych kryteriów. W zależności od zapytania, lokalizacji czy wcześniej odwiedzanych stron użytkownik wyszukiwarki uzyskuje wyniki, które mają jak najtrafniej odpowiadać na wpisaną frazę.

Pełna lista czynników, wpływających na pozycję strony internetowej w rankingu, jest nieznana - jedynie kilka z nich zostało potwierdzonych oficjalnie przez Google. Niektórzy specjaliści SEO podają, że jest ich kilkanaście, inni że kilkadziesiąt, a nawet kilkaset. Ciągły rozwój algorytmów wyszukiwania sprawia, że wyłapanie wszystkich czynników oraz ustalenie ich wagi jest niezmiernie trudne lub wręcz niemożliwe. W zależności od intencji użytkownika, data opublikowania informacji może mieć duże lub bardzo małe znaczenie. Podobnie jest z długością treści.

Dodatkowo, wprowadzenie do algorytmów elementów uczenia maszynowego (machine learning) sprawia, że liczba czynników rankingowych nieustannie się powiększa i ustalana jest nie przez człowieka, a przez maszynę.

Czym są algorytmy Google i jak często są aktualizowane

Algorytm jest to zbiór czynności, jakie trzeba wykonać, by osiągnąć zamierzony efekt. W przypadku algorytmów wyszukiwania Google jest to wyświetlenie wartościowych stron użytkownikom Internetu.

Jak wcześniej wspomniałem, na końcowy efekt widoczny w SERPach, składa się nie jeden, a kilkanaście (może nawet kilkadziesiąt) algorytmów, które segregują, klasyfikują, oceniają i jak wszystko w przyrodzie - nieustannie ewoluują. Dawniej zmiany w algorytmach zdarzały się stosunkowo rzadko i były rozległe. Obecnie niemal codziennie dochodzi do mniejszych lub większych aktualizacji. Część z nich jest jednak na tyle duża, że doczekały się własnych nazw. Warto tutaj wspomnieć o Medical Update z sierpnia 2018 roku, który dla wielu portali okazał się tragiczny w skutkach.

Dobrym źródłem informacji na temat zmian są portale branżowe oraz śledzenie informacji zamieszczanych na portalach społecznościowych przez SEOwców z całego świata.

Problem z widocznością w wyszukiwarce Google?

Zdaj się na specjalistów z KS!

Algorytmy Google i ich aktualizacje od podszewki

PageRank

PageRank był pierwszym algorytmem służącym do oceny stron w nowo tworzonym silniku wyszukiwarki. Stworzyli go Larry Page (od którego nazwiska algorytm zyskał nazwę) oraz Siergiej Brin, jako część swojego projektu naukowego na Uniwersytecie Stanford w 1996 roku. Algorytm opierał się na prostym założeniu. Strony z większą ilością odnośników z innych źródeł są wartościowe i powinny być premiowane wyższymi pozycjami w wynikach wyszukiwania.

Współczynnik PageRank podawał wartość strony w skali od 0 do 10, dzięki czemu w łatwy sposób można było porównać się z konkurencją. Informacje o wartości współczynnika dostępne były przez długi czas w pasku narzędziowym Google (Google ToolBar) oraz w narzędziach dla deweloperów - Google Webmaster Tools (dziś Google Search Console).

Łatwość z jaką można było manipulować algorytmem (choćby poprzez dodanie strony internetowej do tzw. farm linków czy nadmierne stosowanie słów kluczowych w znaczniku meta keywords) wymógł na gigancie z Mountain View stworzenie innych sposobów na klasyfikowanie stron. Rozwój algorytmów, takich Panda czy Pingwin, zaczął marginalizować znaczenie wskaźnika PageRank w ocenie jakości strony, co doprowadziło do całkowitego jego wycofania w 2016 roku.

- Data wprowadzenia: 1998

- Cel: Klasyfikacja stron internetowych w oparciu o ilość linków prowadzących do nich oraz współczynników PageRank tych stron

- Kto zyskał: Strony do, których prowadziła znaczna ilość odnośników

- Kto stracił: Witryny bez prowadzących do nich linków zewnętrznych

Algorytm Google Panda.

Panda (Google Panda)

Walka ze spamem i nieuczciwymi technikami pozycjonowania sprawiły, że w zagrodzie Google pojawił się pierwszy zwierzak. Algorytm Panda, nazwany na cześć inżyniera Navneeta Pandy, został oficjalnie wprowadzony 23 lutego 2011 roku. Na początku działał on jako filtr i nie był częścią głównego algorytmu. Włączenie do głównego algorytmu wyszukującego nastąpiło dopiero w styczniu 2016 roku.

U podstaw wprowadzenia Pandy leżała chęć Google do walki ze stronami słabej jakości, powielanymi treściami czy spamem. Algorytm ma za zadanie podnosić wartość stron uznanych przez niego za wartościowe, a obniżać tym, które nie spełniają kryteriów Google. W skrajnych przypadkach na serwisy zostawały nakładane kary, które skutkowały usunięciem stron z indeksu.

Aktualizacja Pandy, w początkowym okresie jej funkcjonowania, miała miejsce co miesiąc. Od 2013 roku zmiany wprowadzane są w połączeniu z aktualizacjami algorytmu głównego, przez co trudno je powiązać ze zmianami w samej Pandzie.

Działania, których należy się wystrzegać:

- tworzenie stron niskiej jakości lub generowanych automatycznie, o znikomej wartości dla użytkownika (thin content)

- kopiowanie treści z innych stron (duplicate content)

- upychanie słów kluczowych (keyword stuffing) mające na celu sztuczne nasycenie treści wartościowymi frazami

- tworzenie treści wprowadzających użytkownika w błąd poprzez podawanie nieaktualnych lub nieprawdziwych informacji (poor user experience)

Algorytm Google jest nieustannie rozwijany, co wymusza na twórcach nieustanną dbałość o jakość stron w serwisie i treści na nich zawartych.

- Data wprowadzenia: 23 lutego 2011

- Cel: Walka ze stronami niskiej jakości, duplikatami treści i upychaniem słów kluczowych

- Aktualizacje: do 2013 roku co miesiąc, obecnie zmiany są wprowadzane w sposób ciągły

- Kto zyskał: Strony tworzące wartościowe treści

- Kto stracił: Słabe jakościowo portale, gdzie większość treści to duplikaty oraz strony stosujące keyword stuffing

Page Layout / Above the Fold

Aktualizacja algorytmu Above the Fold (pierwsza z serii Page Layout) z 19 stycznia 2012 roku wymierzona została w serwisy, które w sekcji powyżej linii załamania (ang. Above the Fold) zawierały znaczną ilość reklam czy nieużytecznych elementów, zmuszając tym samym użytkownika do przewinięcia strony w dół. Google uznało, że wpływa to na doświadczenia z użytkowania serwisu i wartość takich stron była przez algorytm obniżana. W późniejszym czasie wyszły jeszcze 3 aktualizacje algorytmu (9 października 2012, 6 lutego 2014 oraz 1 listopada 2016 roku). Każda z kolejnych zmian wprowadzała nowe elementy layoutu, które algorytm brał pod uwagę oceniając stronę.

Poza zawartością sekcji Above the Fold zwrócić uwagę trzeba również na to, czy nie blokujemy istotnych dla wyglądu strony plików css, js czy obrazów oraz czy strona spełnia wymagania co do responsywności (lub czy istnieje wersja strony dopasowana do rozdzielczości urządzenia mobilnego).

By nie narazić się na obniżenie rankingu, należy sprawdzić przede wszystkim wygląd sekcji Above the Fold na urządzeniu przenośnym. Dobrym narzędziem do tego będzie poczciwa Search Console (GSC) lub SurferSEO.

- Data wprowadzenia: 19 stycznia 2012

- Data aktualizacji: 9 października 2012, 6 lutego 2014, 1 listopada 2016 roku

- Cel: Obniżenie rankingu stronom, które w polu Above the Fold miały dużą ilość reklam i nieużytecznych elementów

- Kto zyskał: Strony, które oferują użytkownikom wartościowe treści jak najwyżej w układzie strony

- Kto stracił: Serwisy przeładowane reklamami, wymagającymi od użytkownika wykonania interakcji (zamknięcie reklamy, przewinięcie strony poniżej linii załamania)

Algorytm Pingwin.

Pingwin (Google Penguin)

Kolejnym krokiem w stronę poprawy jakości wyników wyszukiwania było pojawienie się następnego algorytmu Google. Pingwin to algorytm odpowiedzialny za ocenę serwisu pod kątem linków prowadzących do niego. Pojawił się on na scenie 24 kwietnia 2012 roku i od tamtej pory stał się jednym z najbardziej rozpoznawalnych algorytmów wyszukiwarki.

Jak działa? Algorytm sprawdza odnośniki prowadzące do strony i obniża wartość stronom, których profil linków wyda się podejrzany. Na celowniku Pingwina znajdują się strony, w których:

- przyrost ilości linków nastąpił gwałtownie,

- anchory linków zewnętrznych zawierają słowa w dopasowaniu ścisłym (exact match),

- odnośniki pochodzą ze słabych jakościowo, spamerskich stron lub portali z automatycznie generowanym contentem,

- linki pochodzą z nieskorelowanych tematycznie stron internetowych.

Algorytm, po wykryciu próby manipulacji profilem linków, nakłada karę na pojedyncze podstrony lub całą witrynę. Obecnie kary ręczne należą do rzadkości, jednak należy pamiętać by ostrożnie i z rozwagą prowadzić działania linkbuildingowe.

Tak jak w przypadku Pandy, algorytm Pingwin doczekał się kilku oficjalnie potwierdzonych poprawek. Ostatnia z nich, ochrzczona przez SEOwców mianem Pingwin 4.0, weszła w życie 23 września 2016. Od tego czasu algorytm działa w ramach algorytmu głównego w czasie rzeczywistym (real-time). Dzięki temu, na bieżąco ocenia on nasze strony pod kątem manipulacji profilem linków.

- Data wprowadzenia: 24 kwietnia 2012

- Cel: Ograniczenie ilości spamu, obniżenie wartości stronom manipulującym profilem linków

- Aktualizacje: 25 maja 2012, 5 października 2012, 22 maja 2013, 4 października 2013, 17 października 2014, 27 września 2016, obecnie zmiany są wprowadzane w sposób ciągły

- Kto zyskał: Strony posiadające urozmaicony profil linków, z odnośnikami prowadzącymi z zaufanych źródeł powiązanych tematycznie

- Kto stracił: Strony z znaczną ilością linków pochodzących ze spamerskich witryn, strony ze zmanipulowanym profilem linków

Algorytm Pirat.

Pirat (Pirate)

Czarna bandera na maszcie Google zawisła w sierpniu 2012 roku. Na wody Internetu wypływa Pirat, aktualizacja algorytmu mająca ukrócić proceder kopiowania treści objętych prawem autorskim. Zadaniem algorytmu jest usuwanie z wyników wyszukiwania stron, które są na bakier z prawem autorskim. Oberwało się serwisom oferującym nielegalne pobieranie filmów, muzyki czy oprogramowania oraz portalom linkującym do tych serwisów.

Google, jak i wiele krajów na świecie, uznało piractwo medialne za nieetyczne i wytoczyło ciężkie działa przeciwko stronom promującym dostęp do objętych prawem autorskim materiałów.

Osoby, które uważają, że na danej stronie zostały naruszone prawa autorskie, mogą zgłosić to na specjalnie do tego przygotowanej stronie - KLIK. Algorytm bada zgłoszenie i jeżeli uzna, że materiały naruszają prawa autorskie, strona zostanie usunięta z indeksu. Właściciel serwisu otrzyma informację w GSC, która podstrona narusza prawa autorskie.

W październiku 2014 roku Pirat doczekał się aktualizacji, która przyczyniła się do większej jego czułości. Google zredukowało ilość zgłoszeń potrzebną do zadziałania algorytmu i usunięcia jej z wyników wyszukiwania lub znaczącego obniżenia jej rankingu.

- Data wprowadzenia: sierpień 2012

- Aktualizacja: Październik 2014

- Cel: Obniżenie rankingu stronom z raportami dotyczącymi naruszeń praw autorskich

- Kto zyskał: Strony z unikalnymi, autorskimi treściami, właściciele praw autorskich

- Kto stracił: Strony powielające bezprawnie informację oraz dystrybuujące materiały objęte prawem autorskim

Phantom - nazwa dla aktualizacji niepotwierdzonych oficjalnie przez Google.

Phantom

9 maja 2013 roku wiele stron zanotowało spadki w ruchu organicznym. Przypuszcza się, że w okolicach tej daty miała miejsce kolejna aktualizacja algorytmu Google, co mogą potwierdzać dane z narzędzia MozCast czy informacje bezpośrednio od twórców serwisów. Samo Google nie potwierdziło, by w tym dniu wypuszczono update wyszukiwarki. Natura zmian w algorytmie pozostaje nieznana, stąd nazwa Phantom (z ang. widmo, upiór, fantom). Spekuluje się, że spadki dotknęły strony, które:

- linkowały do znacznej ilości innych domen poprzez odnośniki dofollow, mimo że same są autorytetami w branży,

- stosowały intensywne linkowanie krzyżowe między stronami siostrzanymi,

- posiadały ryzykowny profil linków (obecny lub historyczny),

- bezprawnie kopiowały treści z innych stron.

Część SEOwców zmiany w algorytmie z maja 2015 roku, z listopada 2015 roku, z czerwca 2016 roku i lutego 2017 roku zaczęła nazywać aktualizacją Phantom z kolejnym numerem. Jedyną częścią wspólną łączącą te uaktualnienia jest fakt, że przez długi czas nikt nie wiedział jakich aspektów dotyczyły zmiany.

- Data wprowadzenia: 9 maj 2013

- Aktualizacja: maj 2015 (?), listopad 2015 (?), czerwiec 2016 (?), luty 2017 (?)

- Cel: Nie jest do końca znany, sugeruje się, że była to aktualizacja jakościowa

Exact Match Domain Update

Przez długi czas SEOwcy, by podnieść pozycję strony na słowa kluczowe z dużą ilością zapytań, wykupywali domeny, w których występowała dana fraza. Taki zabieg pozwalał oszukać algorytm wyszukiwania i sprawiał, że domena z frazą w dopasowaniu ścisłym (tzw. Exact Match Domain - EMD) była lepiej oceniana. Google zauważył problem i 28 września 2012 roku ogłosił wypuszczenie "niewielkiej" aktualizacji, która miała obniżyć znaczenie posiadania słowa w dopasowaniu ścisłym w domenie.

Algorytm sprawdza czy dana nazwa domeny odpowiada nazwie przedsiębiorstwa lub czy domena nie została wykupiona tylko po to, by na daną frazę pojawiać się wysoko w wynikach organicznych nie oferując użytkownikom żadnych pożytecznych informacji.

- Data wprowadzenia: 28 września 2012

- Cel: Obniżenie pozycji niektórym domenom z frazą w dopasowaniu ścisłym

- Kto zyskał: Strony, które przez EMD nie mogły przebić się do pierwszej dziesiątki wyników

- Kto stracił: EMD oferujące niskiej jakości treści

Payday Loan Update.

Payday Loan

Aktualizacja Payday Loan była jedną z ważniejszych aktualizacji w 2013 roku i dotknęła strony, które wysokie pozycje zawdzięczały dużej ilości spamerskich linków z innych witryn. Oberwało się głównie firmom finansowym oferującym pożyczki na wysoki procent oraz tzw. pożyczki do wypłaty (stąd też wzięła się potoczna nazwa update'u) oraz branży pornograficznej. Ilość wejść z wyszukiwarki Google dla tego typu stron gwałtownie spadła.

Wpływ na wyniki był znaczący i szacuje się, że objął ok. 0,3 % wszystkich zapytań w Stanach Zjednoczonych. Ilość zapytań w różnych krajach wahała się znacząco i dla Turcji odsetek zapytań objętych aktualizacją Payday Loan wynosił ok. 4%.

Wypuszczono jeszcze dwa updaty pod nazwą Payday Loan 2.0 (16 maja 2014 roku) oraz Payday Loan 3.0 (12 czerwca 2014 roku). Pierwszy z nich miał na celu obniżenie pozycji bardzo zaspamowanych stron, drugi uderzał w zapytania uznawane przez Google za spamerskie.

Wypuszczenie aktualizacji sprawiło, że techniki Grey i Black Hat SEO stały się bardziej ryzykowne i coraz więcej SEOwców kieruje się wskazówkami dla webmasterów.

- Data wprowadzenia: 11 czerwca 2013

- Aktualizacja: 16 maja 2014, 12 czerwca 2014

- Cel: Obniżenie pozycji stron bazujących na spamerskich odnośnikach z innych witryn oraz posiadających słabej jakości treści w obrębie witryny (keyword stuffing)

- Kto zyskał: Witryny przestrzegające wytycznych Google, działające w obrębie White Hat SEO

- Kto stracił: Strony oferujące szybkie, wysoko oprocentowane pożyczki oraz branża pornograficzna

Google Koliber.

Koliber (Google Hummingbird)

Pojawienie się na scenie Kolibra wskazało drogę, po której obecnie porusza się Google. Algorytm ma na celu lepsze zrozumienie intencji użytkownika, który wpisuje określone zapytanie w okno wyszukiwania. Nie chodzi już o samo słowo kluczowe, ale o to, jakie informacje użytkownik oczekuje znaleźć. Algorytm Google bada zależność między poszczególnymi słowami w zapytaniu i na tej podstawie szereguje wyniki wyszukiwania. Dzięki temu, strony internetowe nie zawierające słowa kluczowego w dopasowaniu ścisłym, mają szansę pojawić się wysoko w SERPach, jeżeli tylko odpowiadają na zapytanie użytkownika.

Na wprowadzeniu Kolibra najbardziej zyskały strony, które niekoniecznie zawierają słowo kluczowe, ale za to pokrywają zakres tematyczny zagadnienia. Dlatego też obecnie optymalizacja stron internetowych polega na tworzeniu i optymalizacji contentu przydatnego użytkownikowi, a nie na sztucznym upychaniu fraz kluczowych w tekście. Wprowadzając Kolibra do algorytmu wyszukiwania, Google chce zachęcić twórców stron do stosowania naturalnego języka oraz pisania dla ludzi, a nie tylko dla robotów.

- Data wprowadzenia: sierpień 2013

- Cel: Dostarczenie użytkownikom trafniejszych wyników wyszukiwań, lepsze zrozumienie zapytań

- Kto zyskał: Strony odpowiadające na zapytania z długiego ogona

- Kto stracił: Strony nie stosujące naturalnego języka w swoich treściach oraz stosujące keyword stuffing

Gołąb (Google Pigeon)

Aktualizacja algorytmu Google o nazwie kodowej Gołąb to zmiana wpływająca na lokalne wyniki wyszukiwań. Wraz z nią istotna stała się lokalizacja użytkownika, dzięki czemu wyniki mogą być lepiej dopasowane do jego intencji.

Aktualizacja została wprowadzona dla fraz anglojęzycznych dwuetapowo. Pierwsza aktualizacja (24 lipca 2014 roku) objęła swoim zasięgiem wyszukiwania lokalne w Stanach Zjednoczonych. 22 grudnia przyszedł czas na Wielką Brytanię, Kanadę oraz Australię.

Wprowadzenie Gołębia przyczyniło się do ujednolicenia wyników wyszukiwań, w których użytkownik użył lub nie informacji o lokalizacji. Takie same czynniki brane są pod uwagę przy szeregowaniu wyników wyszukiwania lokalnych i globalnych. Oznacza to, że wyniki na zapytanie zawierające miasto lub region mogą być zbliżone do tych bez użycia lokalizacji.

Wraz z aktualizacją, na znaczeniu zyskały czynności mogące pomóc w pozycjonowaniu lokalnym, takie jak:

- Data wprowadzenia: 24 lipca 2014 (USA), 22 grudnia 2014 (Wielka Brytania, Kanada, Australia)

- Cel: Lepsze dopasowanie w lokalnych wynikach wyszukiwania

- Kto zyskał: Firmy oferujące usługi lokalnie z dobrze zoptymalizowanymi stronami i uzupełnionymi wizytówkami Google Moja Firma

- Kto stracił: Firmy ze słabo zoptymalizowanymi stronami, błędnymi lub niespójnymi danymi w Internecie, ze źle skonfigurowaną usługa Google Moja Firma, z wprowadzającymi w błąd danymi strukturalnymi.

Aktualizacje Google zwiększające wpływ wersji mobilnej na pozycję w wynikach wyszukiwania - Mobilegeddon | Mobile Friendly Update | Mobile First Indexing.

Mobilegeddon - Mobile Friendly Update

Rozpropagowanie smartfonów i dostępność do szybkiego, a co najważniejsze, taniego Internetu mobilnego przyczyniła się do wzrostu ilości użytkowników przeglądających strony internetowe za pomocą urządzeń mobilnych. Google także zauważyło ten trend i tak oto 21 kwietnia 2015 światło dzienne ujrzała aktualizacja o wdzięcznej nazwie Mobile Update. Wielu spodziewało się rewolucji w wynikach wyszukiwania - stąd potoczna nazwa Mobilegeddon - jednak takowe nie nastąpiły. Owszem, strony z wersją mobilną zaczęły pojawiać się wyżej w SERPach, jednak cały proces rozciągnął się w czasie.

Aktualizacja Mobile Friendly Update podyktowana była szybkim wzrostem ruchu z urządzeń mobilnych i próbą skłonienia twórców stron do ich przystosowania do wyświetlania na mniejszych rozdzielczościach.

Kontynuacją zmian w algorytmie Google, premiującą strony dostosowane do urządzeń mobilnych, była wypuszczona 12 maja 2016 aktualizacja Mobile Friendly 2.

To, czy strona jest przystosowana do niższych rozdzielczości możemy sprawdzić na kilka sposobów. Oto 5 z nich, które na co dzień stosujemy w Agencji KS:

- Skorzystanie z narzędzia Test Optymalizacji Mobilnej - można testować jedną stronę na raz,

- Skorzystanie z narzędzia Mobile-Friendly Bulk Testing Tool - można testować do 20 stron jednocześnie,

- Przejście do zakładki: Obsługa na urządzeniach mobilnych w Google Search Console,

- Przetestowanie witryny na smartfonie,

- Testowanie witryny korzystając z DevTools Chroma w widoku mobilnym.

Należy przy tym pamiętać, że mobilność jest cechą pojedynczej strony. W obrębie domeny mogą znajdować się strony w pełni przystosowane do niskich rozdzielczości jak i takie, które będą zawierać błędy.

Kamieniem milowym było ogłoszenie przez Google przejścia na określenie pozycji strony, uwzględniając w pierwszej kolejności jej wersję mobilną. Mobile First Indexing został uruchomiony 26 marca 2018 roku i stopniowo obejmował coraz większą liczbę domen. Już dziś, dla większości stron, robotem indeksującym jest GoogleBot crawlujący strony przeznaczone dla smartfonów. Pokazuje to, jak bardzo istotna jest strona przeznaczona na urządzenia o mniejszych rozdzielczościach.

- Data aktualizacji: 21 kwietnia 2015 (Mobilegeddon), 12 maja 2016 (Mobile Friendly 2), 26 marca 2018 (Mobile First Index)

- Cel: Podniesienie rankingu stronom dopasowanym do wyświetlania na urządzeniach o niższych rozdzielczościach

- Kto zyskał: Strony responsywne, portale posiadające mobilne wersje w subdomenie

- Kto stracił: Witryny nieprzystosowane do wyświetlania na smartfonach, z nieczytelną treścią czy elementami klikalnymi ustawionymi zbyt blisko siebie

RankBrain - sztuczna inteligencja w wyszukiwarce.

RankBrain

RankBrain to sztuczna inteligencja, system uczenia maszynowego, który do algorytmu został wprowadzony w 2015 roku. Oficjalnie Google potwierdziło jego istnienie 26 października 2015 roku oraz zaznaczyło, że jest to trzeci najważniejszy czynnik w ustalaniu pozycji stron internetowych.

Zapytania wpisywane przez użytkowników z wyszukiwarkę stają się coraz bardziej zawiłe. Nie chodzi już tylko o frazy kluczowe, ale o to by dostarczyć treści jak najlepiej dopasowane do intencji wyszukującego. Takie założenia posłużyły za stworzenie algorytmu samouczącego się RankBrain. Algorytm porównuje słowa i frazy oraz szuka powiązań między nimi. Dzięki temu także strony niezawierające słowa kluczowego mogą osiągać wysokie pozycje, jeżeli tylko algorytm uzna, że spełnią one oczekiwania użytkownika.

- Data wprowadzenia: nieznana, oficjalne potwierdzenie istnienia algorytmu: 26 października 2015

- Cel: Zwracanie wyników wyszukiwania lepiej dopasowanych do intencji użytkownika

- Kto zyskał: strony dbające o pozytywne doświadczenia użytkownika

- Kto stracił: witryny z dużym współczynnikiem odrzuceń czy powodujące, że użytkownik wchodzi na stronę i wraca do wyników wyszukiwania (pogo sticking).

Aktualizacja Opos.

Opos (Possum)

Szereg zmian w algorytmie, przeprowadzonych przez Google w okolicach września 2016 roku, miało istotny wpływ na lokalne wyniki wyszukiwań. Opos, bo taką nazwę otrzymały te aktualizacje, uzależnił wyniki lokalnych wyszukiwań od fizycznej lokalizacji użytkownika. Dzięki temu, małe przedsiębiorstwa działające na lokalnym rynku, mają szansę wypromować się w wyszukiwarce. Zyskały również przedsiębiorstwa, które swoją siedzibę mają poza danym miastem.

Dodatkowo, przedsiębiorstwom dzielącym ten sam adres z inną firmą o podobnym profilu działalności, został obniżony ranking. Ma to zapobiegać tworzeniu wizytówek tej samej firmy z różnymi nazwami w celu dominacji w wynikach wyszukiwania.

Firmy, które chcą wyświetlać się wysoko w wynikach wyszukiwania, powinny zadbać o tzw. pozycjonowanie lokalne, które składa się m.in. z utworzenia i ciągłej aktualizacji wizytówki Google My Business, optymalizacji strony z uwzględnieniem lokalizacji i pozyskaniem wzmianek w katalogach i na stronach lokalnych.

- Data wprowadzenia: 1 września 2016

- Cel: Lepiej dopasowane wyniki wyszukiwania uzależnione od fizycznej lokalizacji użytkownika

- Kto zyskał: Lokalne firmy oraz firmy oferujące usługi w danym mieście, ale posiadające siedzibę poza jego obrębem

- Kto stracił: Firmy dzielące ten sam adres fizyczny z przedsiębiorstwem o podobnym profilu

Google Intrusive Interstitials Mobile Penalty

Google coraz większą wagę przykłada do zadowolenia użytkowników korzystających z Internetu na urządzeniach mobilnych. Szereg zmian w algorytmie wymusza na twórcach stron, by były one w jak największym stopniu przystosowane do smartfonów i tabletów. 10 stycznia 2017 roku Google posunęło się o krok dalej i wprowadziło kary dla serwisów, które utrudniały dostęp do treści wyświetlając użytkownikom natrętne pełnowymiarowe reklamy (Intrusive Interstitials). Portale, które od razu po wejściu użytkownika na stronę, serwowały mu reklamę zasłaniającą tekst, narażają się na obniżenie rankingu (co przekłada się na spadki w pozycjach) a nawet na penalizację, czyli usunięcie z indeksu Google.

Nie wszystkie typy wyskakujących okienek zasługują na karę. Wśród wymienionych przez Google dozwolonych typów są informacje o plikach cookies czy blokady wiekowe dla treści nieodpowiednich dla nieletnich.

- Data wprowadzenia: 10 stycznia 2017

- Cel: Penalizacja stron z natrętnymi, pełnoekranowymi reklamami utrudniającymi dostęp do treści

- Kto zyskał: Strony stosujące preferowany przez Google formy reklamy

- Kto stracił: Portale z pełnoekranowymi reklamami wyskakującymi zaraz po wejściu na stronę

Medical Update - aktualizacja, która uderzyła w strony związane z branżą medyczną i finansową.

Medical Update

Jedna z największych aktualizacji, która w znacznym stopniu przyczyniła się do spadku widoczności wielu portali i serwisów została wypuszczona początkiem sierpnia 2018 roku. Największe spadki zanotowały strony zaliczane do kategorii Your Money Your Life czyli związane z naszym zdrowiem i pieniędzmi. W związku z tym świat SEO ochrzcił tę aktualizację Medical Update.

Google wyszło z założenia, że te dziedziny życia są niezwykle istotne i nie może pozwolić, by użytkownik trafiał na fałszywe lub wprowadzające w błąd informacje. Zapowiedź większych zmian w algorytmie można było przewidzieć na podstawie uaktualnienia wytycznych dla pracowników oceniających strony internetowe, w których to większy nacisk położono na jakość treści, właściwe oznaczenie głównej zawartości strony, czy umiejscowienia elementów reklamowych w obrębie Main Content.

Sierpniowy Update dotknął także naszych klientów o czym więcej przeczytasz w tym artykule - Case Study: Odzyskanie pozycji strony YMYL po sierpniowej aktualizacji algorytmu Google.

- Data wprowadzenia: 1 sierpnia 2018

- Cel: Dostarczenie użytkownikowi wyszukiwarki Google wiarygodnych i rzetelnych odpowiedzi na pytania z branży medycznej i finansowej

- Kto zyskał: Strony dbające o jakość treści potwierdzone autorytetem autora

- Kto stracił: Portale i serwisy klasyfikowane jako YMYL, które nie odpowiadały wytycznym (na przykład: reklamy w Main Content)

March 2019 Core Update

Pierwszym dużym updatem algorytmu wyszukiwania w 2019 roku była aktualizacja wprowadzona w marcu. Google, poprzez oficjalne konto na Twitterze, potwierdziło wdrożenie poprawek oraz zasugerowało również nazwę dla tej aktualizacji: March 2019 Core Update. Tak jak przy Medical Update i aktualizacji z października 2018 roku, największe zmiany w pozycjach stron odnotowały witryny podejmujące tematykę zdrowia (choć Google zaprzecza jakoby update wymierzony był w tę branżę). Największe wzrosty odnotowały strony z dużym autorytetem z szerokim zakresem tematycznym. Z kolei niszowe strony www, zajmujące się tylko wycinkiem danego zagadnienia, odnotowały w tym czasie znaczące spadki.

Niektóre analizy (np. te przeprowadzone przez Malte Landwehr z Searchmetrics) wskazują na to, że strony internetowe, które poprawiły sygnały od użytkowników, zyskały w oczach algorytmu. Może to oznaczać, że Google bierze pod uwagę także zachowanie użytkownika na stronie. W przytoczonej analizie, strony które zyskały, cechowały się niższym współczynnikiem odrzuceń, dłuższym czasem przebywania na stronie oraz większą ilością stron odwiedzanych przez użytkownika w czasie jednej sesji.

Jedno jest pewne. Chcąc utrzymać wysokie pozycje, należy dbać o unikalne, wysokiej jakości treści, dopasować się do intencji użytkownika (czy potrzebuje on szybkiej informacji czy artykułu tłumaczącego dogłębnie temat) oraz zadbać o pozytywne doświadczenia w obcowaniu ze stroną - nieinwazyjne reklamy, ograniczona liczba pop-upów czy też zadowalająca szybkość ładowania się strony.

- Data wprowadzenia: 12 marca 2019

- Cel: Lepsze dopasowanie wyników do intencji użytkownika

- Kto zyskał: Portale cieszące się dużym autorytetem z szerokim zakresem tematycznym, które oferują pozytywne doświadczenia dla użytkownika.

- Kto stracił: Niszowe strony zajmujące się niewielkim obszarem dotyczącym medycyny oraz portale negatywnie wpływające na doświadczenia użytkownika (długie ładowanie się strony, nadmierna ilość wyskakujących reklam, inwazyjne reklamy).

Site Diversity Update

Wpisując wybraną frazę,otrzymujemy zestaw wyników wyszukiwania, w których dana domena występuje raz. Zdarzają się przypadki, że dwa lub trzy miejsca w pierwszej dziesiątce, mocna, dobrze zoptymalizowana domena. Dzieje się tak przeważnie przy sklepach, gdzie na jedną frazę mogą pojawiać się trzy strony - produktowa, kategoria i strona główna. Jeszcze rzadziej mamy do czynienia z sytuacją, gdzie wyniki wyszukiwania zdominowane są przez jedną domenę.

Z takimi anomaliami ma walczyć wprowadzona stosunkowo niedawno aktualizacja Site Diversity. Od 6 czerwca 2019 roku wyniki wyszukiwania na słowa kluczowe będą zawierały maksymalnie dwa adresy z tej samej domeny (choć Google przewiduje wyjątki). Subdomeny będą traktowane jako część domen, a zmiany dotknęły tylko główną wyszukiwarkę.

- Data wprowadzenia: 6 czerwca 2019

- Cel: Ograniczenie ilości wyników wyszukiwania z jednej domeny do maksymalnie dwóch adresów

- Kto zyskał: Strony z dalszych miejsc w wynikach wyszukiwania (przez wprowadzone ograniczenia, mogą pojawiać się wyżej w wynikach wyszukiwania)

- Kto stracił: Serwisy, które dominowały w SERPach na niektóre zapytania (kilka wyników w pierwszej 10)

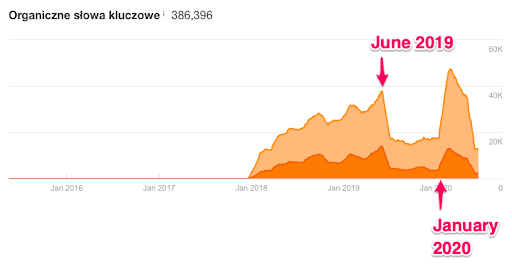

June 2019 Core Update

Wraz z nastaniem czerwca 2019 roku, Google po raz pierwszy z wyprzedzeniem poinformowało o aktualizacji algorytmu wyszukiwania. Za pośrednictwem konta na Twitterze już 2 czerwca pojawiła się informacja o planowanym wdrożeniu aktualizacji czerwcowej. Aktualizacja June 2019 Core Update - bo takie miano ona otrzymała - wprowadzona została dnia następnego - 3 czerwca - a cały proces wdrażania trwał do 8 czerwca.

Jak w przypadku pozostałych update'ów, brak jest oficjalnych informacji, co tak naprawdę zostało poprawione czy zmienione. Jedynie sygnały od seowców z całego świata pozwalają domniemywać, czego mógł dotyczyć update.

Wśród największych przegranych znalazły się portale, takie jak dailymail.co.uk. czy cnn.com. W przypadku tej ostatniej witryny straty w ruchu organicznym szacowane są na ponad 50%, a widoczność na urządzeniach mobilnych spadła o ponad 70%. Sama domena odzyskała pełną widoczność z nawiązką po update'cie w styczniu 2020 roku.

Ilość słów w pierwszej 10 dla domeny cnn.com. Widoczny jest gwałtowny spadek ilości fraz w Top10 po czerwcowym update'cie. Duży wzrost z kolei zaczął pojawiać się po styczniowej aktualizacji. Obecnie, od lutego 2020 domena notuje nieustanny spadek.

W środowisku zauważono też pewne powiązanie z poprzednim dużym update'em. Mianowicie, część stron internetowych, które ucierpiały w marcu, otrzymała rekompensatę w widoczności po czerwcowej aktualizacji.

Główne przyczyny spadków upatruje się w słabym UX na urządzeniach mobilnych, dużą ilością reklam, wolnym ładowaniem się witryny czy niskiej jakości treściom. Nie bez znaczenia był również wątpliwy autorytet autora publikacji.

Po raz kolejny pojawiły się też pytania, jak ustrzec się przed spadkami wynikłymi z aktualizacji algorytmów. Nie ma niestety złotego środka. W takich przypadkach ważne jest konsekwentne budowanie wysokiej jakości treści, dbanie o pozytywne odczucia użytkowników oraz pielęgnacja serwisu od strony technicznej. Nawet jeżeli domena ucierpiała w wyniku jednego update'u, przy kolejnym może otrzymać solidny bonus w widoczności.

- Data wprowadzenia: 3 czerwca 2019

- Cel: Poprawa jakości wyników wyszukiwania

- Kto zyskał: Serwisy, które utraciły ruch w wyniku marcowej aktualizacji i takie, które dbają o pozytywne odczucia użytkownika z wysokiej jakości treściami.

- Kto stracił: Portale z nadmierną ilością reklam, z długim czasem oczekiwania na załadowanie się zawartości, ze słabej jakości treściami czy słabym UX na urządzeniach mobilnych.

September 2019 Core Update

Kolejna duża aktualizacja głównego algorytmu Google w 2019 roku. Tak jak w przypadku dwóch poprzednich (March 2019 i June 2019), także i tutaj Google zasugerowało nazwę, by uniknąć zamieszania jakie wynikło przy okazji aktualizacji marcowej.

Podobnie do innych aktualizacji głównego algorytmu, możemy jedynie domniemywać czego dotyczył ten update. Wśród spostrzeżeń i analiz, można znaleźć takie, które mówią o poprawie pozycji dla stron z mocnym profilem linków. Z kolei inni seowcy zauważyli, że na niektóre słowa kluczowe w TOP10 znalazły się witryny ze słabszym profilem linków, jednak z lepsza treścią zapewniającą gruntowne pokrycie tematyki.

Ciekawym wnioskiem wysuniętym z analizy skutków czerwcowego update'u jest zwiększenie trafności dla treści prezentowanej w formie wideo dla niektórych informacyjnych słów kluczowych. Zauważono m.in. że strony, które długo okupowały pierwsze miejsca na te frazy, spadły na pozycję 4, a na ich miejsce wskoczyła karuzela z filmikami. Mimo iż pozycja 4 nadal mogła być traktowana jako pierwszy tradycyjny wynik organiczny, to w wyniku takich działań dramatycznie mogła zmienić się ilość wejść na stronę. Niektóre frazy zyskały kolejne snippety - takie jak Feature Snippets czy People Also Ask), co dodatkowo utrudniało użytkownikowi dotarcie do wyników organicznych.

Co gorsza, spadki w ilości wejść na stronę z wyników organicznych nie powodowały spadków w narzędziach do monitorowania pozycji, które to mają problem z braniem pod uwagę dodatkowych funkcjonalności SERPów.

Miesiąc wcześniej, Google na blogu dla webmasterów, zamieściło informację o tym, czego można spodziewać się przy kolejnych aktualizacjach i jak należy na nie reagować. Google nieustannie pracuje nad poprawą oceny treści, przez co w wyniku kolejnych aktualizacji niektóre strony tracą, a inne zyskują. Oznacza to, że strony, które wcześniej ucierpiały, mogą odzyskać ruch przy kolejnych updatach.

Jednocześnie, Google zaznacza, że spadki w wynikach wyszukiwania nie muszą oznaczać, że z naszą stroną jest coś nie tak. Za przykład podawana jest strona z rankingiem 100 najlepszych filmów. W chwili publikacji będzie ona aktualna i wartościowa. Jednak po kilku latach może ona nie zawierać filmów, które zostały w międzyczasie wydane, a które zasługują na pojawienie się na tej liście. Aktualizując informacje zawarte w starszych artykułach, możemy zminimalizować skutki kolejnych update'ów.

- Data wprowadzenia: 24 września 2019

- Cel: Poprawa oceny jakości treści

- Kto zyskał: Witryny ze słabszym profilem linków, ale lepszymi, wyczerpującymi tematykę treściami, Youtube.

- Kto stracił: Strony rankujące na frazy, które zyskały dodatkowe funkcje w wynikach wyszukiwania (karuzela filmów, feature snippet, powiązane pytania).

Google BERT Natural Language Processing Update.

Google BERT Natural Language Processing Update

BERT (Bidirectional Encoder Representation from Transformers) to największa od 5 lat aktualizacja algorytmu, która swoim zasięgiem objęła ok 1/10 wszystkich wyszukiwań na świecie. Jej głównym celem było dostarczenie lepszych i trafniejszych wyników wyszukiwania na frazy long-tail. Dzięki włączeniu przetwarzania naturalnego języka (Natural Language Processing) do algorytmu, Google zyskało możliwość lepszej interpretacji treści, a przez to dostarczania użytkownikowi wyszukiwarki lepiej dopasowanych odpowiedzi.

Od grudnia 2019 roku BERT działa już dla 70 języków (w tym także dla języka polskiego), przeważnie dla fraz long-taliowych i póki co nie musimy obawiać się, że nastąpią gwałtowne przetasowania dla fraz z jasną intencją wyszukującego.

Jak zaznacza samo Google, nie jest możliwa optymalizacja stron pod BERTa. Spadki czy wzrosty nie stanowią kary lub nagrody, ale są wynikiem zmiany rozumienia intencji użytkownika przez algorytm.

Wprowadzenie BERTa to kamień milowy na drodze do otrzymywania trafniejszych odpowiedzi. Coraz więcej ludzi w pole wyszukiwania wpisuje dłuższe frazy i oczekuje sprecyzowanej odpowiedzi już w wyszukiwarce (lub przynajmniej jasnej deklaracji, że na danej stronie taką odpowiedź uzyska). Ponadto, w dobie szybkiego rozwoju wyszukiwań głosowych, algorytmy codziennie muszą mierzyć się ze sformułowaniami przypominającymi bardziej komunikację między ludźmi niż na linii człowiek - maszyna. Od właściwej interpretacji zapytania zależy czy użytkownik otrzyma odpowiedź na nurtujące go pytanie, czy zostanie z niczym. Ponadto, szacuje się, że ok 15% wszystkich zapytań to zapytania całkowicie nowe, z którymi algorytm musi radzić sobie w miarę szybko, aby utrzymać wysoki poziom zadowolenia dla sztandarowej usługi Google.

- Data wprowadzenia: październik 2019 (zapytania anglojęzyczne) grudzień 2019 (rozszerzenie na 70 języków)

- Cel: Lepsze zrozumienie intencji użytkownika i trafniejsze dopasowanie wyników wyszukiwania dla fraz long-tail

- Kto zyskał: Strony internetowe lepiej odpowiadające na długie zapytania użytkowników

- Kto stracił: Witryny, których treści nie korelują z intencją użytkownika.

January 2020 Core Update

Nowy rok Google rozpoczął z przytupem. Już w pierwszej połowie stycznia na Twitterze pojawiła się informacja o wypuszczeniu aktualizacji głównego algorytmu. Gigant z Mountain View kontynuuje tradycję zapoczątkowaną w marcu 2019 roku i kolejnym aktualizacjom nadaje własne nazwy. Ta otrzymała miano January 2020 Core Update.

Z krótkiej informacji zamieszczonej na oficjalnym koncie Google na Twitterze dowiedzieć się można jedynie, że wskazówki o tym jak postępować w przypadku aktualizacji algorytmów pozostają niezmienne.

Styczniowa aktualizacja algorytmu głównego - tak jak i poprzednie Core Update - ma na celu poprawę doświadczeń użytkowników wyszukiwarki. W głównej mierze chodzi o lepsze dopasowanie wyników do intencji użytkownika czy zaprezentowanie mu gotowej odpowiedzi od razu w wyszukiwarce. Aktualizacji algorytmu nie należy traktować jako kary dla stron, a spadki i wzrosty wynikają ze zmian mających poprawić jakość usługi. Z tego też powodu nie sposób wypracować skutecznej strategii mającej na celu odzyskanie utraconych pozycji. Jedynie co pozostaje to nadal dbać o jakość serwisów i liczyć na to, że kolejny update będzie łaskawszy.

- Data wprowadzenia: 13 stycznia 2020

- Cel: Dostarczenie użytkownikowi wyszukiwarki trafniejszych wyników.

Problem z widocznością w wyszukiwarce Google?

Zdaj się na specjalistów z KS!

May 2020 Core Update

Do zmian w algorytmach Google seowcy zdążyli już się przyzwyczaić. Wdrażanie tych największych poprzedzone jest wysłaniem informacji przez rzecznika Google ds. SEO Danny'ego Sullivan'a.

4 maja 2020 roku poinformował on o kolejnej dużej zmianie w algorytmie wyszukiwania, która zgodnie z ostatnimi poczynaniami Google otrzymała nazwę May 2020 Core Update. Próżno jednak szukać informacji, co tak naprawdę zostało zmienione lub poprawione. Google przez ostatnie kilkanaście miesięcy wdraża większe lub mniejsze poprawki, które mają polepszyć jakość korzystania z ich flagowej usługi.

Nie zawsze zmiany w algorytmach są z korzyścią dla stron dostarczających wysokiej jakości treści swoim czytelnikom. Wielokrotnie już mieliśmy przypadki, kiedy to jeden update głównego algorytmu powodował olbrzymie spadki, a w kolejnym ruch wracał z nawiązką. Także i po tej aktualizacji powinniśmy się spodziewać korekt, które choć w części zrekompensują utratę ruchu.

Przy każdym większym przetasowaniu w wynikach wyszukiwania, pojawia się kwestia tego jak reagować na zmiany w algorytmach wyszukiwania Google. Nie ma złotej rady i nawet przestrzeganie wytycznych Google, dbanie o techniczne aspekty czy jakość treści nie uchroni przed nagłym spadkiem wynikłym z aktualizacji.

- Data wprowadzenia: 4 maja 2020

- Cel: Dostarczenie użytkownikowi wyszukiwarki trafniejszych wyników.

Podsumowanie

Algorytmy Google nieustannie ewoluują i są dostosowywane do zmieniających się warunków w Internecie. Wystarczy spojrzeć na aktualizacje dotyczące wyświetlania na urządzeniach przenośnych. Gdyby nie dynamiczny rozwój smartfonów i możliwości przeglądania Internetu także w podróży, takie zmiany nie byłyby konieczne.

W jednym artykule nie sposób wymienić i opisać wszystkich uaktualnień. Jest ich po prostu zbyt wiele, a z czasem będzie ich przybywać. Jednego możemy być pewni. Algorytmy katalogujące strony będą coraz bardziej rozwinięte i mniej podatne na manipulację. Część z nich zostanie (lub już została) przystosowana do samodzielnego uczenia się, przez co czynniki rankingowe, brane pod uwagę przy układaniu wyników w SERPach będą nieustannie się zmieniać.

Mam nadzieję, że artykuł ten choć trochę przybliżył sposób działania wyszukiwarki Google oraz wyjaśnił, jakie algorytmy są odpowiedzialne za wyniki widoczne po wpisaniu określonej frazy lub pytania w okno wyszukiwania.